Démonstrations

Les sessions démos prévues au programme seront décomposées en séquences d’une 1/2 heure, chaque séquence correspondant à un groupe de 6 personnes (contrainte de sécurité). Au total, 90 participants aux journées sont donc susceptibles d’assister à l’une des démonstrations décrites ci-dessous. Les démos 1 et 2 sont chacune programmées sur 2 sessions (36 participants assisteront exclusivement à l’une ou l’autre) ; la démo 3 ne pourra se dérouler que sur une session (seulement 18 participants pourront la voir).

L’inscription aux démonstrations se fera au bureau d’accueil des journées, situé près de l’amphi BLANDIN. Deux règles seront strictement appliquées :

- tout participant ne pourra s’inscrire qu’à une séance de démonstration d’une seule session ;

- les participants n’ayant pas eu l’opportunité de venir au meeting inaugural EuroVR-EVE 2010 de mai dernier seront « prioritaires ».

Nous vous remercions par avance de votre compréhension.

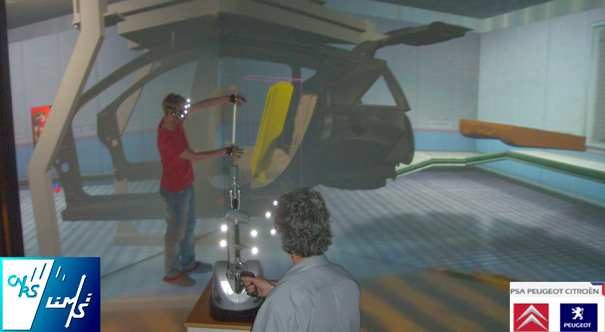

Demo 1 « Interaction multimodale et collaborative en immersion co-localisée : exemple de scénario d’usage dans l’industrie automobile »

La configuration double-stéréoscopie du système EVE permet en particulier à l’équipe VENISE de mener des études comparatives entre plusieurs types de collaborations immersives : celles dites distantes par rapport à celles qui sont co-localisées, mais aussi au sein de ces dernières les apports et limites de la multi-stéréoscopie. Ce démonstrateur donne donc un aperçu de l’état actuel de la plate-forme logicielle développée dans l’objectif de cette étude, mais présente aussi à notre connaissance le premier système immersif gérant de façon intégrée les interactions multimodales et collaboratives.

Le scénario de la démonstration est une tâche de collaboration de deux

utilisateurs pour des activités de formation ou de conception dans

l’industrie automobile. Dans une chaîne d’assemblage virtuelle, les utilisateurs coopèrent pour définir la trajectoire d’un siège qui doit être inséré dans l’habitacle d’une voiture. Par exemple, un apprenti manoeuvre un siège en utilisant les commandes vocales et le dispositif haptique

afin d’analyser les trajectoires d’insertion possibles. Dans le même temps un tuteur contraint la tâche de l’apprenti en définissant des guides virtuels (par exemple, des axes ou des plans) à l’aide de commandes vocales et/ou gestuelles. Par ailleurs, la plate-forme logicielle peut être utilisée dans une tâche de conception collaborative. Dans ce cas, le système gère la commutation d’un utilisateur à l’autre en détectant celui qui tient l’organe terminal du dispositif haptique. De plus, l’utilisateur du périphérique

haptique peut définir des guides virtuels additionnels avec des

commandes vocales et des gestes réalisés avec sa main libre. Ce démonstrateur a été réalisé dans le cadre du projet Digiteo « SIMCoD » en partenariat avec le CEA-LIST, Haption SA et PSA Peugeot Citroën.

Le scénario de la démonstration est une tâche de collaboration de deux

utilisateurs pour des activités de formation ou de conception dans

l’industrie automobile. Dans une chaîne d’assemblage virtuelle, les utilisateurs coopèrent pour définir la trajectoire d’un siège qui doit être inséré dans l’habitacle d’une voiture. Par exemple, un apprenti manoeuvre un siège en utilisant les commandes vocales et le dispositif haptique

afin d’analyser les trajectoires d’insertion possibles. Dans le même temps un tuteur contraint la tâche de l’apprenti en définissant des guides virtuels (par exemple, des axes ou des plans) à l’aide de commandes vocales et/ou gestuelles. Par ailleurs, la plate-forme logicielle peut être utilisée dans une tâche de conception collaborative. Dans ce cas, le système gère la commutation d’un utilisateur à l’autre en détectant celui qui tient l’organe terminal du dispositif haptique. De plus, l’utilisateur du périphérique

haptique peut définir des guides virtuels additionnels avec des

commandes vocales et des gestes réalisés avec sa main libre. Ce démonstrateur a été réalisé dans le cadre du projet Digiteo « SIMCoD » en partenariat avec le CEA-LIST, Haption SA et PSA Peugeot Citroën.

Demo 2 « SACARI : Téléprésence pour le pilotage à distance »

La Réalité Augmentée est le processus par lequel un contenu virtuel 3D est superposé en temps réel à la perception réelle de l’utilisateur, afin de lui fournir des informations utiles pour une tâche donnée. La Virtualité Augmentée est le processus symétrique, qui superpose un contenu réel capturé à distance dans une simulation de Réalité Virtuelle.

Ce démonstrateur présente l’état actuel de l’interface SACARI (Supervision of an Autonomous Car in an Augmented viRtuality Interface), un travail de recherche en Virtualité Augmentée mené depuis quelques années au sein de l’équipe VENISE. Avec l’interface SACARI, une utilisateur peut conduire à distance un fauteuil roulant électrique grâce à un canal vidéo stéréo temps-réel et un canal audio 3D. Les qualités acoustiques uniques du système EVE et de sa halle permettent une télé-immersion sonore de type ambisonique. Ces données réelles seront recalées à terme sur une description virtuelle de l’environnement 3D du véhicule afin de faciliter le processus de conduite.

Demo 3 "SMART-I² : une fenêtre sur des espaces spatialisés audio-vidéo"

La plate-forme SMART-I² (Spatial Multi-users Audio-visual Real-Time Interactive Interface) propose de vous immerger dans un monde 3D audio-visuel virtuel.

Le rendu 3D visuel utilise la stéréoscopie passive, alors que le rendu audio est réalisé grâce à la Synthèse de Front d’Ondes (Wave Field Synthesis). Ces deux technologies sont associées pour créer une extension virtuelle tangible du monde physique, et illustrer ainsi les bénéfices apportés par les techniques de rendu audio avancées à la vidéo 3D. Le WFS permet de créer les paysages audio virtuels dans lesquels la position des sources sonores est restituée avec précision pour un grand nombre d’utilisateurs, même pour des sources situées devant l’écran. Des scènes virtuelles simples seront proposées aux utilisateurs afin de comparer des techniques stéréophoniques classiques au rendu WFS. Des améliorations en termes de sensation d’immersion et d’intelligibilité audio des scènes virtuelles seront également présentées. Une partie de la démonstration montrera l’intégration avec la plateforme d’humains virtuels du LIMSI : MARC.